こんにちは。ごるごです。

研究室の宿題で線形代数を勉強しなければならないので、ついでにこのブログで勉強の記録も付けていきたいと思います。テキストはこちらになります。

基本的にはテキストをざっくりと翻訳していく形になるかと思います。ところどころ日本語があやしい箇所がありますがご容赦ください(できればコメントで添削してほしい)。また、諸事情によりChapter 12のLeast Squaresから始めます。

それでは、スタート

Chapter 12 Least squares

この章では、連立一次方程式の誤差の二乗和を最小化することで、over-determined*1 な連立方程式の近似解を求める強力な手法を学ぶ。その手法と、後の章で記載されるいくつかの拡張は幅広い分野に応用されている。最小二乗法は19世紀にガウスとルジャンドル二人の数学者によって独立に発見された。

12.1 Least squares problem

型の係数行列

が縦長であるとき、連立方程式は

と表され、

が

次元ベクトルであるので、この連立方程式は over-determined となる。すなわち、方程式の数

が選択できる変数の数

よりも多い。これらの方程式は、

が

の各列の線形結合であるときのみ解をもつ。

しかし、ほとんどの において、

を満たす

次元ベクトル

は存在しない。妥協案として、我々は残差

を最小化する

を探すことにする。つまり、残差のノルム

を最小化するということである。もし残差ベクトルが小さくなるなら、

であると言える(いくつかの本では残差は

と定義されるが、

であるため差し支えない)。

残差のノルムを最小化することと残差の二乗を最小化することは同義であるため、

すべての

(我々が元々の残差のノルムと呼ぶところの)

データフィッティングへの応用(次章のトピックである)で典型的に用いられる最小二乗法(12.1)の他の名称は回帰(regression)である。最小二乗解

列の解釈

の各列が

次のベクトルであるとき、最小二乗法(12.1)は

次ベクトル

に最も近い各列の線形結合を求める問題となる。つまり、ベクトル

は係数を与える。

行の解釈

の各行が

次の行ベクトル

であるとすると、残差の成分は次のように与えられる。

つまり、

Example

次のようなデータをもつ最小二乗法を考える。

行の解釈は我々に

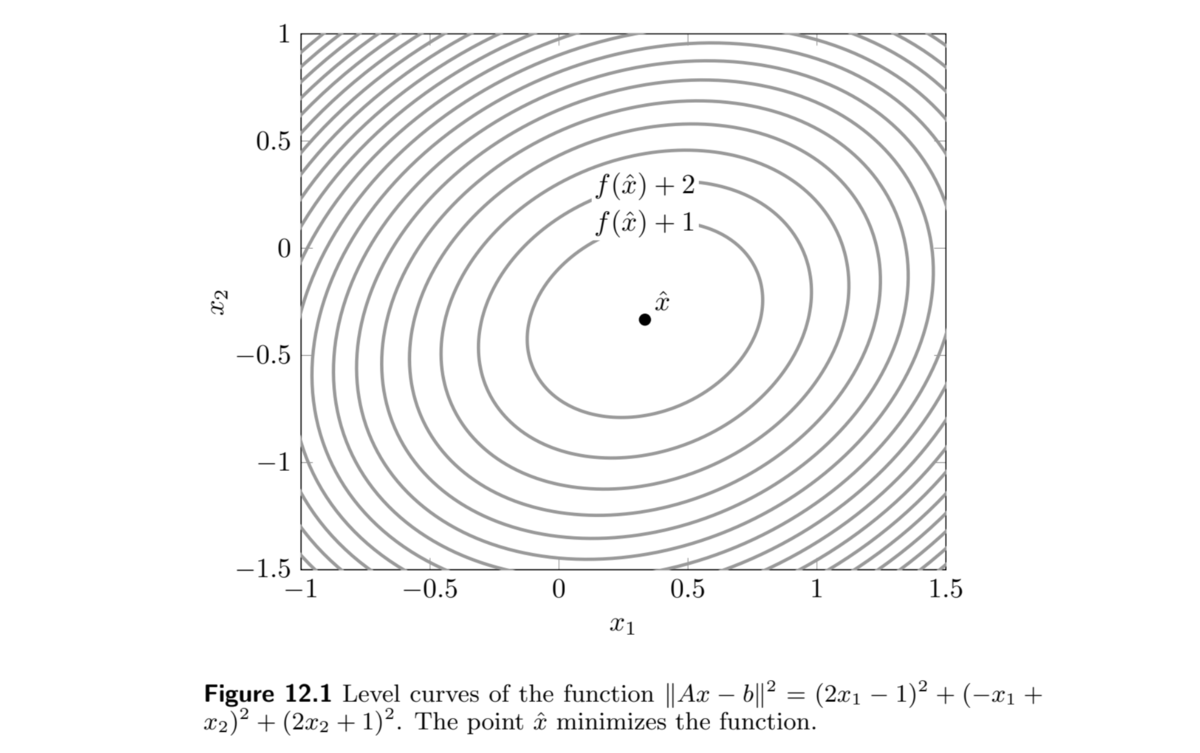

図 12.1 は

次回→VMLS 12.2